IA embarquée : des processeurs neuronaux 10 fois plus économes en énergie, basés sur l’open source de Nvidia

La start-up fabless grenobloise Neurxcore annonce une gamme complète de processeurs neuronaux écoénergétiques adaptés à un large éventail d’applications, comme la vision artificielle et l’IA générative (ChatGPT, par exemple). Ces puces d’accélération de réseaux neuronaux (Neural Processing Unit ou NPU) sont basées sur une version largement modifiée et étendue d’un cœur d’accélération open-source NVDLA du géant américain des processeurs graphiques Nvidia.

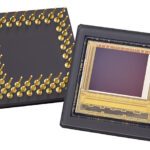

La technologie SNVDLA de Neurxcore a été qualifiée sur silicium à l’aide du process de fabrication 22nm du fondeur TSMC. Une carte électronique intégrant ce processeur neuronal a été réalisée, cette dernière permet de valider la fonctionnalité et démontrer l’efficacité du composant via l’exécution d’applications d’IA comme la reconnaissance d’images.

Les solutions SNVDLA de Neurxcore comptent établir de nouvelles normes en termes d’efficacité énergétique et de performances. Les accélérateurs d’IA sont jusqu’à 1000 fois plus rapides qu’un processeur classique et 100 fois plus rapides qu’un processeur graphique, tout en offrant une efficacité énergétique exceptionnelle, avance la start-up. Le SNVDLA promet à terme une économie d’énergie ou une performance environ 10 fois supérieure par rapport aux solutions commerciales équivalentes actuelles grâce à une technologie brevetée de calcul en mémoire développée au niveau transistor.

Les processeurs de Neurxcore combinent des technologies propriétaires brevetées avec le cœur d’accélération ouvert NVDLA de Nvidia. Ces processeurs neuronaux sont proposés sous forme de licences. Les clients peuvent obtenir une licence Neurxcore pour intégrer cette technologie dans leurs systèmes sur puce, permettant une personnalisation et une intégration aisée de celle-ci.

À court terme, la société proposera également des processeurs Neurxcore sous forme de puces en silicium prêtes à être intégrées dans des boîtiers, appelés « chiplets ». En combinant ces chiplets Neurxcore avec d’autres chiplets réalisant différentes fonctions (Bluetooth, caméra, etc.), on crée un système en boîtier. Cette approche multipuce, contrairement à un seul système sur puce, offre plus de flexibilité dans certains cas, notamment en permettant la combinaison de différents processus de fabrication, tout en optimisant les coûts en termes de densité, d’intégration et de scalabilité.

Neurxcore propose également le kit de développement logiciel Heracium (SDK) permettant d’optimiser l’exécution des réseaux de neurones sur ses produits. La gamme de produits de Neurxcore répond à un large éventail d’industries et d’applications, allant de l’ultra-basse consommation aux scénarios haute performance, comprenant des capteurs et l’Internet des objets (IoT), des dispositifs portables, des smartphones, des maisons intelligentes, la surveillance, les décodeurs TV et numériques, les téléviseurs intelligents, la robotique, le calcul en périphérie, la réalité augmentée/virtuelle, les systèmes avancés d’aide à la conduite (ADAS), les datacenters, etc.

Selon Gartner, le marché des semiconducteurs IA pourrait atteindre 111,6 milliards de dollars d’ici 2027, avec un taux de croissance annuel moyen de 20% sur cinq ans.

L’importance de l’inférence en IA

L’inférence sur laquelle Neurxcore se focalise, consiste à utiliser des modèles IA pour effectuer des prédictions ou générer du contenu. La phase d’inférence représente l’exécution d’un modèle une fois qu’il a déjà été entraîné. Plus de 80% des tâches sont liées à l’inférence, tandis que seulement 20% sont liées à l’apprentissage. Cette phase est cruciale dans de nombreuses applications, y compris celles nécessitant un service simultané à plusieurs utilisateurs. L’apprentissage se déroule principalement dans les datacenters, tandis que l’inférence a lieu partout, des capteurs aux voitures en passant par les ordinateurs portables et les serveurs. Des études menées par les GAFA montrent que l’inférence consomme 60% de l’énergie dans les datacenters, avec une augmentation significative ces dernières années, en particulier avec l’émergence de l’IA générative, ce qui renforce la nécessité de processeurs IA dédiés et écoénergétiques.

« Nous sommes extrêmement fiers d’avoir été capable d’atteindre de telles performances, et du travail de l’équipe derrière ce produit révolutionnaire. Ces réalisations sont le fruit de notre engagement envers l’innovation, et nous sommes maintenant prêts à accueillir de nouveaux clients et à développer des collaborations futures avec l’industrie, qui joueront un rôle essentiel dans notre succès à venir », s’enthousiasme Virgile Javerliac, fondateur et p-dg de Neurxcore.